在Windows11的WSL上运行Llama2-7b-chat 下

上一篇博客讲了我跑Llama的demo的心路历程(上一篇博客传送门),这篇我们主要是讲下怎么配置。

快速开始

使用Linux、Linux、Linux,重要的事情说三遍,如果你和我一样懒得安装双系统,那么在Windows下安装一个WSL2。我假设大家都有了WSL2,并且开了ubuntu系统,我们需要做如下操作:

1. 安装Anaconda:如何在Linux服务器上安装Anaconda(超详细) 感谢这位博主

2. 配置git的代理:WSL2 cannot access Windows proxy、WSL2网络代理配置(apt与git)

3. 获取代码,获取的方式很多反正能拿到代码就行:git clone https://github.com/facebookresearch/llama.git

4. 使用代码仓库的 download.sh 下载模型,下载之前先去这个网站填表Meta模型下载申请。开源了个寂寞,扭扭捏捏的。

- 下载模型请选择:llama-2-7b-chat

- 太贪了什么都得不到。。。

5. 安装Llama所需的各种库

pip install -e .6. 运行demo

torchrun --nproc_per_node 1 example_chat_completion.py \

--ckpt_dir llama-2-7b-chat/ \

--tokenizer_path tokenizer.model \

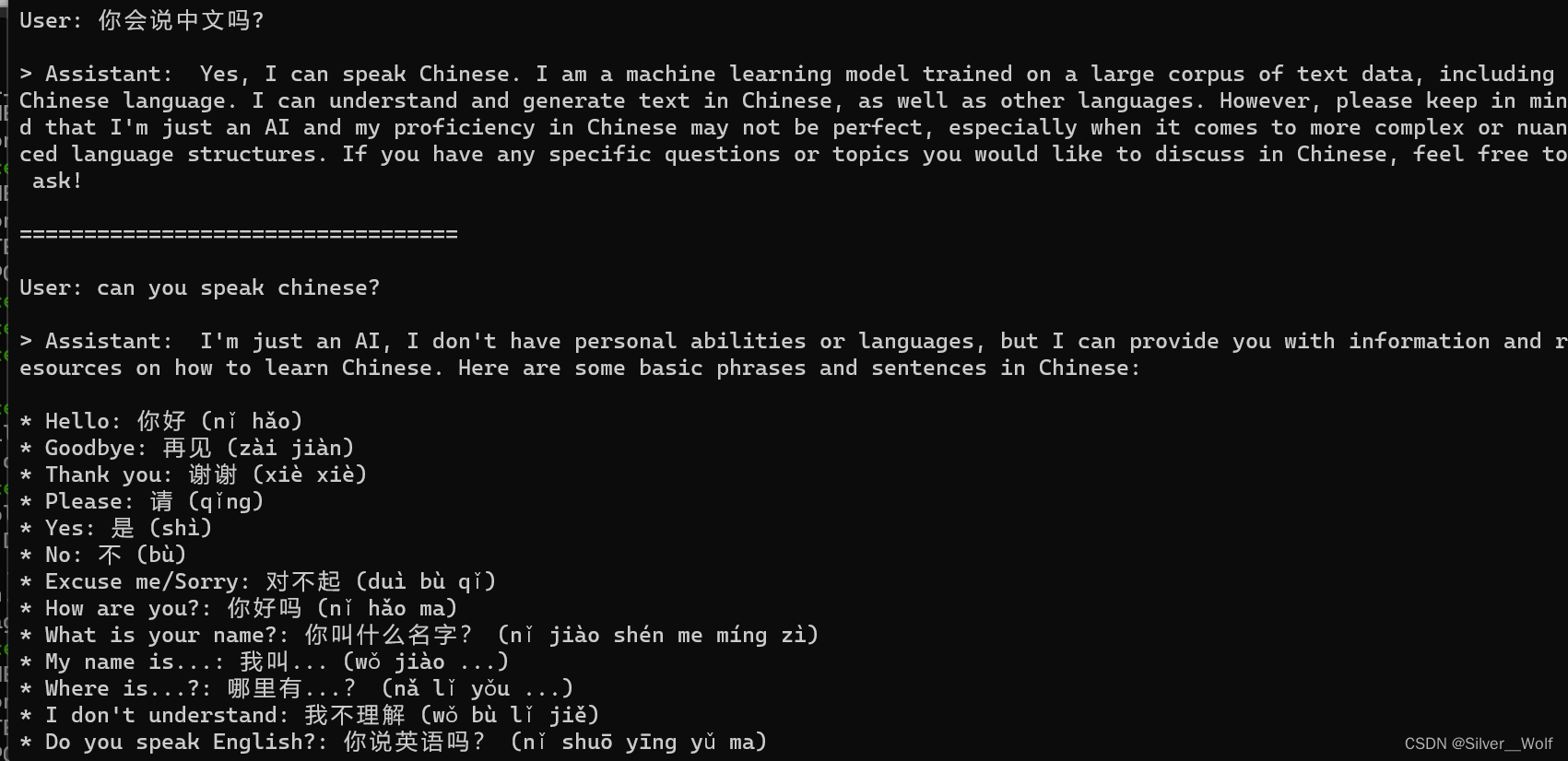

--max_seq_len 512 --max_batch_size 67. 官方demo没有持续对话,需要自己做修改,按照他们的格式改,我改过的输出如下:

8. 我倒是想用gradio做一个页面,但是我没有界面。。。。后续有时间再看

结尾

这就是我在Windows上运行Llama的经历了,血泪教训:用Linux!!!

如果觉得文章对你有用请点赞、关注 ->> 你的点赞对我太有用了

群内交流更多技术

130856474 <-- 在这里